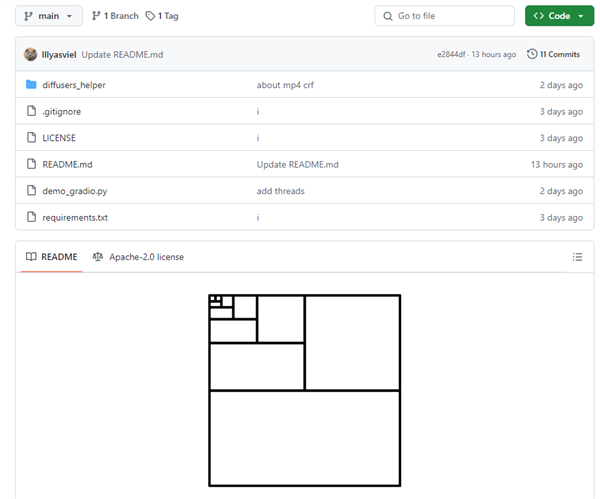

GitHub的Lvmin Zhang和斯坦福大学的Maneesh Agrawala推出了一项创新技术FramePack,通过固定时域上下文,提高视频扩散模型的效率,从而实现更长、更高质量的视频生成。

实验显示,依托FramePack的130亿参数模型在6GB显存下即可输出60秒的视频。

FramePack采用神经网络架构和多级优化策略,支持本地AI视频生成。

尽管其基础是定制版腾讯混元模型,现有任何预训练模型都可经FramePack微调适配。

传统视频扩散模型生成视频时,要先处理带噪帧,再预测更少噪音的后续帧。输入帧量根据视频大小调整,对显存要求高,一般需12GB,否则生成视频短且质量差。

FramePack根据重要性压缩输入帧,形成固定上下文长度,降低显存需求,计算消耗与图像扩散模型类似。

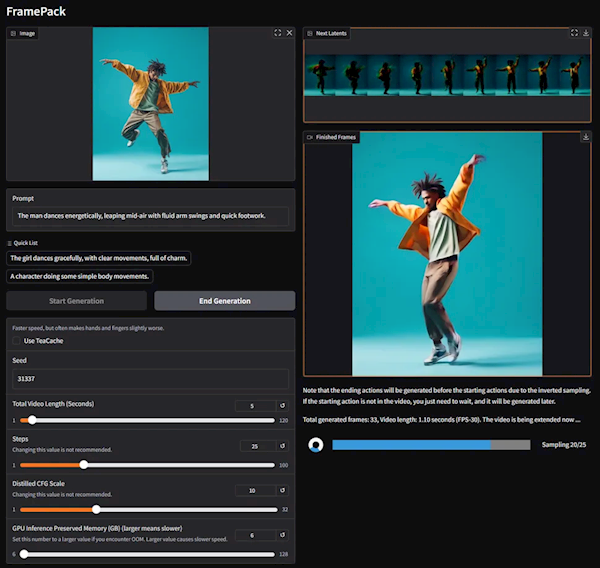

每帧生成后即时显示,方便实时预览。

FramePack缓解了“漂移”现象,提升视频长度而不显著牺牲质量。

FramePack支持FP16、BF16格式,兼容RTX 50、40、30系列显卡,RTX 3050 4GB除外,未测试RTX 20及更老显卡,不涉及AMD、Intel处理器需求。

Windows和Linux操作系统均可运行。

性能优化下,经过teacache的RTX 4090每秒生成约0.6帧。